Une édition particulière ce mois-ci :

est en vacances, donc je vais occuper plus de place dans ce Tech Away d’avril :)📐L’édition de ce mois-ci sera plutôt orienté architecture et conférences !

🦆 Le replay de la Duck Conf’ 2025 est en ligne !

Le replay de La Duck Conf’ de mars 2025, une conférence organisée par OCTO et dont je fais partie de l’équipe de curation, est désormais disponible sur Youtube !

🐥 La Duck Conf’, c’est la première conférence en France entièrement dédiée à l’architecture de SI

🗣️ Cette année, on a abordé des sujets tels que les plateformes (notamment lors de la keynote d’ouverture de Jean-François Landreau, co-auteur du livre Platform Strategy qu’il a rédigé avec Gregor Hohpe), les MicroFrontends, le Domain-Driven Design, la Developer Experience et bien évidemment l’IA, incontournable ces temps-ci.

📹 La playlist Youtube avec tous les talks de cette année 2025 - lien

🤖🧑💻💰 La dette socio-technique de l’IA

🏎️ Architecture toujours : la Fast Flow Conf, conférence officielle sur le thème de Team Topologies a eu lieu fin mars à Amsterdam. N’ayant pas pu m’y rendre, je me suis contenté du replay arrivé rapidement sur Youtube début avril.

Dans les thèmes de cette année, on (re)trouve bien entendu

des retours d’expérience de pratiquants de Team Topologies dans diverses organisations,

quelques usuals suspects quand il s’agit de parler d’organisation, de flow et de DDD sur scène : Susanne Kaiser, Manuel Pais ou Kenny Baas-Schwegler,

du Platform Engineering, de la Developer Experience et de l’orga en général.

🧠 Pour ma part, j’ai été marqué par le talk de Thiago De Faria, actuellement architecte chez AWS semble-t-il, qui a tenu un talk sur la dette sociotechnique que l’IA peut faire peser sur nos organisations, et notamment son impact sur la troisième loi de Conway, que j’ai découvert au passage :

There is never enough time to do something right, but there is always enough time to do it over

Si l’IA s’est invitée massivement dans le quotidien des équipes de développement, Thiago souligne un effet dont on parle peu pour le moment : l’impact de l’IA sur la charge cognitive des individus

Certaines équipes arrivent à s’en servir efficacement et voient leur charge cognitive diminuer, mais dans la majorité des contextes l’IA a plutôt tendance à en ajouter :

on délègue à l'IA la création d’artéfacts qu’on aurait produit nous-même auparavant (du code, un compte-rendu de réunion, un rapport, …)

ce sont des livrables qu'on ne créé pas nous-même (c’est l’IA qui le fait) mais sur lesquels on doit rendre des comptes (en l'envoyant à notre manager par exemple), donc cela nous ajoute de la charge cognitive sur la vérification

Thiago introduit au passage une nouvelle abstraction que je trouve intéressante : le stewardship (qu’on traduirait en français par “travail d’intendance” ?) :

You don't design the plan, you don't design the how,

you design what you want, you give some context and you get an outcome

Cette dette sociotechnique prend la forme d’une redistribution de la charge cognitive due à l’IA :

on a tendance à trop s’appuyer sur l’IA, et cela peut nuire à notre pensée critique

on ajoute des process qui n'étaient pas là auparavant pour contrôler ce que l'IA a produit

l'IA donne accès à plus de documents que ce à quoi l'individu pouvait accéder auparavant, ça permet de "dépasser certaines frontières organisationnelles",

des fois c'est bien, des fois moins en termes de charges cognitives

au lieu de se parler entre équipes, on passe par le LLM qui indexe le Wiki de l'équipe d'à côté et on prend des décisions sur la base de pages de documentation peut-être pas à jour.

Pour y remédier, il donne enfin quelques conseils pratiques en conclusion :

Cartographiez les flux d’informations dans votre organisation

🟧 Faites des Event Storming, plein !

Soyez au clair sur comment vérifier l'output de vos interactions avec de l'IA avant de vous en servir ou d'automatiser des process avec

Former vos équipes à la GenAI : la plupart des gens qui s’en servent n'ont aucune idée de comment ça marche, de comment ou si ces IA "raisonnent", ou comment faire du "bon" prompt engineering

Entretenir des moments de réflexions "AI-free", pour entretenir notre pensée critique (cf. le papier de Microsoft cité plus haut)

La playlist avec tous les talks de la Fast Flow Conf’ 2025 - lien

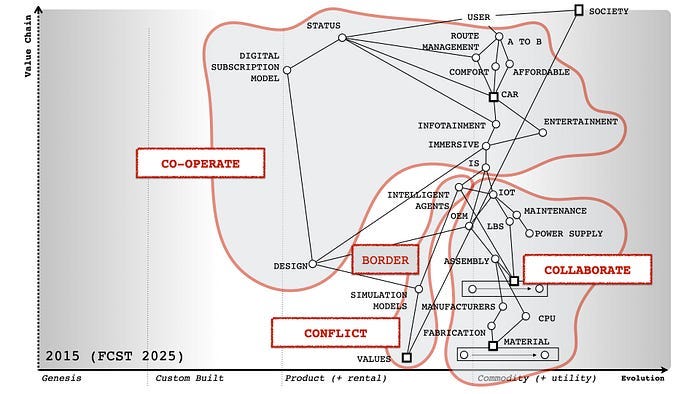

🗺️ Cartographiez votre souveraineté numérique avec les cartes de Wardley

Ce mois-ci, j’ai lu ces 3 articles sur le blog Medium de Simon Wardley qui constituent son essai “On Digital Sovereignty”.

Vous connaissez probablement ce personnage de par les “cartes de Wardley” et la discipline associée de “cartographie de Wardley” (aka Wardley Mapping dans la langue de Jay-Z).

🦆 Si vous n’êtes pas familier avec la discipline, je ne saurais que trop vous recommander la meilleure introduction au sujet en français à ma connaissance : ce talk d’Olivier Wulveryck, c’était à La Duck Conf’ 2024 (l’année dernière)

L’exercice de l’essai est nécessairement abstrait par nature, et dans celui-ci on est servi en termes d’abstraction puisque ces 3 articles parlent de souveraineté, de données, de propriété, de culture.

L’essai décrit notamment une frustration de l’auteur : les débats autour de la souveraineté numérique des nations s’enlisent fréquemment dans des considérations que l’auteur juge superficielles, comme parler uniquement de propriété ou de localisation des données. Le réflexion ne va pas assez loin.

Most discussions I come across on digital sovereignty degenerate into stories about data ownership without clear borders and demands to own parts of the stack without an understanding of the landscape & what matters — Source

Simon Wardley nous explique comment la discipline de la cartographie peut aider à identifier des tendances, dessiner des frontières numériques, faire des choix pour décider de ce qu’il est pertinent de protéger (dans ces frontières) ou non, comprendre les risques, clarifier les responsabilités.

C’est un essai que je trouve intéressant, qui mêle cartographie, stratégie, géopolitique, systémique, culture … Mais je reste tout de même sur ma faim : j’ai l’impression d’avoir pris de la hauteur sur ces sujets avec cette lecture, mais je ne sais pas quoi faire de ces nouveaux outils et perspectives. Faudrait peut-être que je dessine des cartes plus souvent.

🛰️ Le Tech Radar de Thoughtworks #32 est sorti

Le fameux radar à la sortie bi-annuelle est paru en avril, c’est l’occasion de confirmer des intuitions, découvrir des nouveautés ou faire le plein d’arguments d’autorité pour gagner des débats avec vos collègues 😈

ℹ️ Légers rappels sur le fonctionnement de ce radar

Si vous êtes familier avec le radar Thoughtworks, vous pouvez passer à la partie suivante, autrement :

Le radar sert à projeter des “blips” : des technologies ou techniques logicielles,

Le radar est découpée en 4 “rings”:

Adopt. Des éléments qu’il faut sérieusement envisager d'utiliser.

Trial. Des choses prêtes à être utilisées, mais qui ne sont pas encore aussi éprouvées que celles de la catégorie "Adopt".

Assess. Des éléments à examiner de près, mais pas nécessairement à essayer pour l’instant - sauf si vous pensez qu’ils conviendraient particulièrement bien à votre situation.

Hold. À utiliser avec prudence.

🔎 Du côté de l’Exec Sum

Les quelques grandes tendances que l’on trouvera en introduction du radar :

🧠 L’expansion des agents d’IA dans nos IDE

Si les auteurs du radar sont encore sceptiques sur la capacité d'un agent à être complètement autonome sur une base de code pour des tâches au périmètre large, force est de constater que les “AI coding assistants” ont envahit nos éditeurs de code préférés.

Les techniques d’assistance dans le code se développent : on parle d’agents et d’”agentique”, de prompt-to-code ou encore de CHOP (pour chat-oriented programming). Les outils aussi se multiplient : Cline et Cursor font leur place en trial, Windsurf est mentionné en adopt.

La technique “complacency with AI-generated code”, apparu en octobre 2024 dans le radar persiste en hold dans cette édition, avec une mention au vibe coding dont nous parlions déjà dans la 8e édition de cette newsletter, et aussi une mention au papier de Microsoft que je citais plus haut dans ce Tech Away, cité dans le talk de Thiago De Faria, sur l’impact de la GenAI sur notre pensée critique.

🕵️ Du mouvement du côté de l’Observabilité

Sans surprise, l’observabilité est un thème de plus en plus présent, par le fait que nous construisons de plus en plus de systèmes distribués. Je note aussi deux tendances liées aux développements des LLM :

l’observabilité des LLM : pour mieux comprendre ce qui se passe à l’entraînement comme lors de l’inférence.

l’observabilité assistée par LLM : utiliser des LLM pour réaliser des analyses plus fines lors de certaines opérations sur la production

Si OpenTelemetry était en trial en septembre 2023, il figure désormais en adopt avec cette édition du radar. On notera aussi l’apparition en trial de certains outils qui composent la stack LGTM : Loki, Tempo (et Alloy).

🔠 Le R de RAG : cette lettre est importante

Je découvre dans ce radar quelques variations du RAG (Retrieval Augmented Generation) obtenues en faisant varier les techniques de retrieval :

Corrective RAG : on ajuste les réponses du système de RAG selon le feedback utilisateur ou selon des heuristiques

Fusion-RAG : on combine des sources de données et des stratégies de "retrieval" pour avoir des réponses plus complètes ou plus robustes

Self-RAG : j’ai été initialement intrigué par le radar qui décrivait que l’intérêt de cette approche de RAG était … d’éviter le R de RAG. A la lecture du papier sur ce sujet, je comprends que l’idée est d’alterner entre retrieval et self-reflection pour limiter des erreurs qui surviennent quand le R est réalisé systématiquement.

FastGraphRAG : une implémentation de RAG qui propose une modélisation en graphes parcourables par un humain pour faciliter l’explication des résultats produits.

🎆 Autrement, je note en vrac

Adopt : Le Fuzz Testing, en s’appuyant sur l’IA générative pour produire des tests et (mieux/plus) observer le comportement d’un système,

Adopt : Produire des SBOM (Software Bill of Materials), je m’attends donc à en voir de plus en plus en artéfacts de nos pipelines de CI, et c’est tant mieux,

Adopt : Sans surprise, on voit des outils comme Renovate arriver en Adopt

Et la perche nous est tendue de merger automatiquement les PR produites par ces outils de gestion de dépendances 👀 (mais c’est en trial pour le moment)

Adopt : A la fois surpris de la vitesse à laquelle cet outil est arrivé en adopt, mais pas si surpris vu que je l’ai moi-même adopté rapidement : uv, un incontournable pour les pythonistes 🐍

Hold: Replacing pair programming with AI, que je vais simplement ajouter à ma collection d’intuitions confirmées par ce radar

Hold : SAFe™️(oui, oui), avec un blip qui résonne avec quelques expériences que j’ai pu avoir avec ce framework

We see continued adoption of SAFe™ (Scaled Agile Framework®). We also continue to observe that SAFe’s over-standardized, phase-gated processes create friction, that it can promote silos and that its top-down control generates waste in the value stream and discourages engineering talent creativity, while limiting autonomy and experimentation in teams

🛰️ Le reste du radar est consultable sur le site de Thoughtworks - lien

⛓️💥 Quelques liens en vrac pour finir

Pour les nostalgiques de la WeeklyCuration, voici quelques liens que j’ai trouvé intéressant ce mois-ci, mais que je n’aurais pas le temps de commenter :

🙏💸 Être poli avec ChatGPT coûte "des dizaines de millions de dollars" à OpenAI

🧰 OpenAI Codex CLI - Lightweight coding agent that runs in your terminal

OpenAI Said to Be In Talks to Buy Windsurf for About $3 Billion - Bloomberg

🗣️ La conférence Agile Meets Architecture, c’était à Berlin au début du mois d’avril

🗣️ Le replay de la KubeCon+CloudNativeCon qui a eu lien en avril 2025 à Londres est aussi disponible sur la chaîne Youtube de la CNCF : lien 📹

📝 Top 10 Platform Engineering Takeaways from PlatEngDay & KubeCon London 2025 (Daniel Bryant, Syntasso)

🎮🎨🖌️ CSS Hell