🌊🐋 DeepSeek R1 : le tsunami venu de Chine

Par

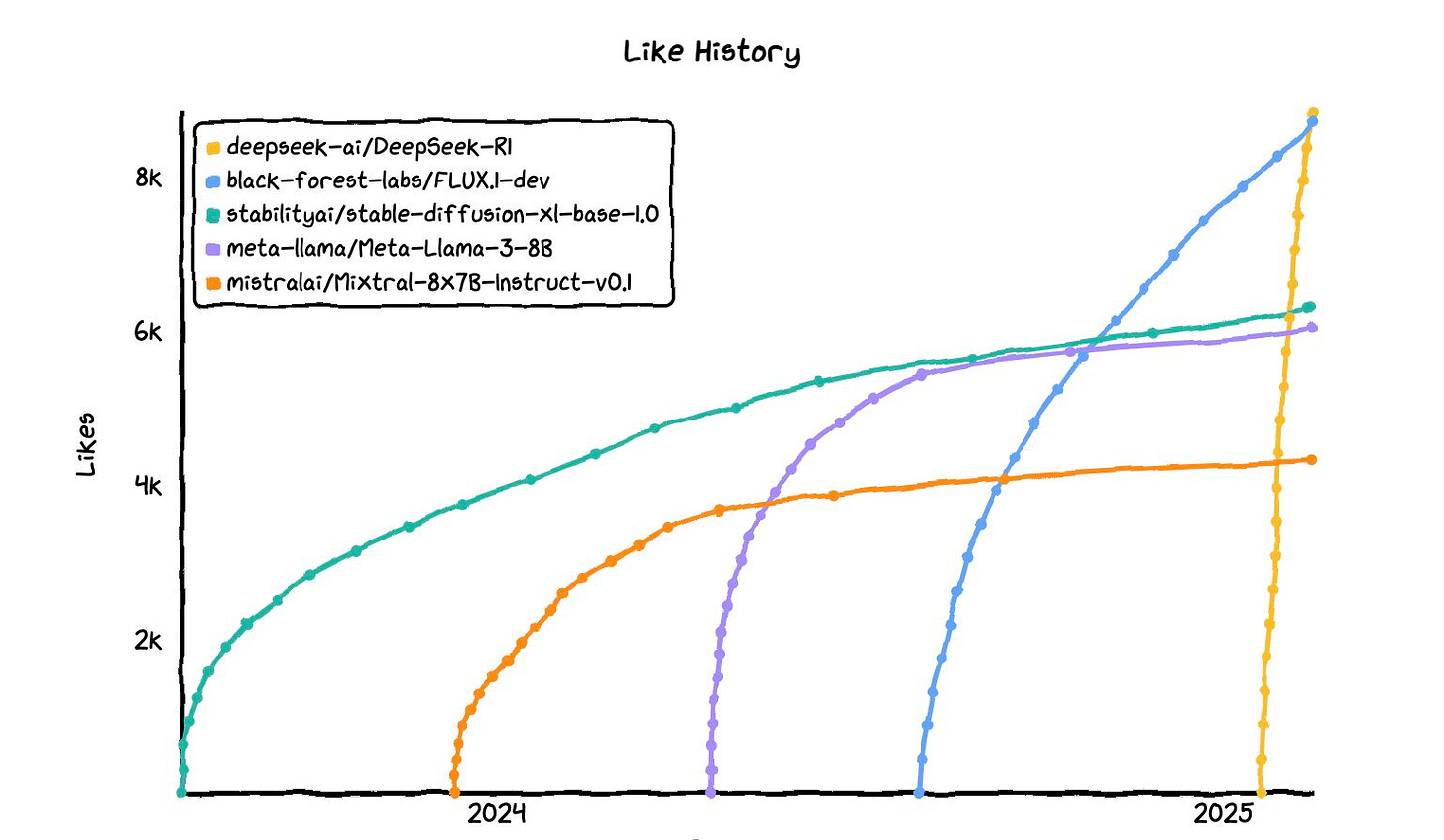

Je ne pouvais pas commencer cette section sans parler de DeepSeek R1, le modèle qui a fait trembler le monde de l’IA en ce début d’année, surtout aux États Unis. 1 200 milliards de dollars en capitalisation boursière envolés en un jour, dont 600 milliards pour NVIDIA.

Devenue rapidement la 1ère application sur l'App Store, elle s’est, dans la foulée, faite DDoS et a subi une fuite de données assez sévère, avec notamment une exposition des logs contenant l’inférence.

Il y a par ailleurs eu beaucoup de bruit autour des 5,6 millions de dollars dépensés pour l’entraîner, souvent comparés aux 500 milliards de dollars d’investissements sur Stargate annoncés par les États Unis presque en même temps. Rappelons que, contrairement à ce qu’ont laissé entendre plusieurs titres de presse, ces deux chiffes ne sont aucunement comparables. Le premier se concentre sur le coût à faire tourner les cartes graphiques pour entraîner DeepSeek V3, le modèle fondationnel derrière R1. Il ne compte pas le coût d’achat des cartes graphiques, le temps de calcul nécessaire aux expérimentations ni à la génération de données synthétiques (pour plus de détails sur le vrai coût de DeepSeek, voir l’article de Semi Analysis). Le second concerne, lui, un investissement sur de l’infrastructure nécessaire à l’entraînement de modèles, étalé sur quatre ans.

Notons aussi la réaction mitigée des géants du secteur :

OpenAI a salué la performance de son compétiteur, puis a déclaré au Financial Times avoir des preuves que DeepSeek a utilisé ses modèles pour s’entraîner.

Le CEO d’Anthropic a à la fois appelé à un embargo plus strict sur les puces pour la Chine, et relativisé la performance de son rival chinois, jugeant qu’elle se situe dans les ordres de grandeurs attendues d’un modèle qui sortirait à cette même période. La seule originalité étant que ce soit une entreprise chinoise qui l’ait produit, ce qu’il juge dangereux pour le “monde occidental”.

Les acteurs de l’open source préfèrent voir cette percée comme la victoire des modèles open weight plutôt que celle de la Chine. Yann LeCun critique les sorties de ses compétiteurs closed weights, tout en saluant la performance et l’approche ouverte de DeepSeek.

Hugging Face en a profité pour lancer Open R1, cherchant à rendre encore plus ouvert ce modèle, en creusant notamment son papier de recherche.

Vous ne l’avez pas encore essayé ?

Vous pouvez le tester directement sur le chat DeepSeek ou via leur API. Gardez juste en tête que les données arriveront en Chine. 🇨🇳

Si vous préférez un service de droit étasunien, hébergé aux États-Unis (ou en Europe, ce n’est pas clair pour le service à la demande), vous pouvez utiliser l’API de Fireworks. 🇺🇸

Le modèle est disponible sur HuggingFace. Vous ne pourrez pas le faire tourner sur votre PC, mais vous pouvez télécharger une des versions distillées et quantisées.

Perplexity en a sorti une version “dé-censurée” : R1 1776 qu’il a rendue disponible sous licence MIT sur HuggingFace. Elle sera (bientôt ?) disponible via leur API Sonar. 🇺🇸

⚠️ Je ne suis pas allée creuser toutes les conditions d’utilisation, mais cela va sans dire : n’envoyez pas des informations sensibles avant de les avoir lues.

Pour aller plus loin : DeepSeek a lancé la “Open source week” afin de “partager [leur] petite mais sincère contribution [à la construction de l’AGI] en toute transparence”. Elle est en cours en ce moment même : je vous laisse la découvrir en suivant le tag #OpenSourceWeek sur LinkedIn.

🧠📞🧠 2025 : l’année de la télépathie et des brain-computer interfaces (BCI) ?

Par

Ce mois-ci, j’ai lu 2 articles assez surprenant sur la télépathie, mais est-ce assez pour dessiner une tendance ? 🤔

A Year of Telepathy (Neuralink)

Le 5 février est paru sur le blog de Neuralink cet article : A Year of Telepathy. Il décrit un retour d’expérience de 3 américains atteints de paralysie des bras et des jambes et qui ont accepté de participer à un test clinique pour se faire implanter une puce Neuralink.

L’article présente leur quotidien avant et après la pose de l’implant : on découvre par exemple le quotidien de Noland qui interagissait auparavant avec une tablette qu’il contrôlait en manipulant un stylet avec sa bouche et qui peut désormais la manipuler par la pensée : il poursuit ses études, écrit, joue à des jeux vidéos, utilise les réseaux sociaux et manipule sa playlist musicale de façon plus autonome qu’auparavant.

Brain2Qwerty (Meta AI)

Ce papier de Meta est paru le 6 février : après le speech2text, le text2speech, le word2vec, la famille des Any2Any se dote d’une nouvelle transformation inattendue : le Brain2Text, et plus précisément le Brain2Qwerty. Il s’agit ici d’un modèle qui s’appuie sur l’activité cérébrale (la magnétoencéphalographie) pour prédire des phrases qu’un humain s’imagine taper sur un clavier QWERTY.

On parle ici d’une approche non-invasive (pas besoin d’opération ou d’implants), qui peut aider des patients privés de moyens de communication et qui surpasse l’état de l’art précédent : le character-error-rate (CER) moyen de ce modèle est de 32% là où l’EEG (Electroencéphalographie) donne un CER moyen de 67%.

A Year of Telepathy (Neuralink)

Brain-to-Text Decoding: A Non-invasive Approach via Typing (Meta AI)

🗣️💻 Vibe coding : l’avenir du métier de développeur ?

Par

Début février, Andrej Karpathy a publié un post très enthousiaste pour partager son expérience de programmation assistée par IA lors de ces dernières semaines : le Vibe Coding.

Il décrit cette “approche” de la programmation comme un nouveau mode d’interaction avec le code, rendant d’une certaine façon cette activité plus accessible : ici, on ne code plus soi-même, on délègue l’écriture du code à une IA via des prompts rédigés en langage naturel dans des IDE comme Cursor (avec l’assistant Composer) ou des commandes vocales (retranscrites en Voice2Text avec des outils comme SuperWhisper, par exemple).

Karpathy parle de “vibe coding” en un sens qui m’évoque la notion de flow (au sens de Mihály Csíkszentmihályi ) : tout semble mis en oeuvre pour maintenir le concepteur de logiciel dans un flux de création, en déléguant à l’IA les “sources de distractions techniques” (comprendre: taper au clavier, trouver le bon raccourci clavier, comprendre puis résoudre des erreurs console, …).

🤔 Faut-il y voir le retour du mythe du “10x Developer” ? Devons-nous jeter le TDD à la poubelle ? Je n’ai moi-même pas de retour d’expérience de cette “pratique” de la programmation, je suis preneur de vos retours !

🍿 Je vois cependant que ce post de Karpathy, bien que récent, suscite déjà beaucoup de réactions, tant enthousiastes qu’accusatrices, que je vais me contenter d’énumérer, si vous souhaitez prolonger la lecture sur ce sujet :

🕵️♀️ Laisser le temps à un agent AI de creuser un sujet avec la recherche profonde

Par

Qui a dit que notre seule façon d’interagir avec un agent est de chatter en temps réel ? L’introduction de fonctionnalités de “recherche profonde” par certains acteurs est un avant-goût d’un nouveau type d’expérience utilisateur, où l’agent prend du temps pour générer une réponse élaborée, puis nous notifie lorsque notre réponse est prête.

🔒 Options fermées

OpenAI a ouvert le bal, en proposant à ses utilisateurs payants de poser des questions que Deep Research ira creuser plus en profondeur. Il prend 5 à 30 minutes et vous envoie une notification lorsqu’il a terminé. Perplexity propose cela en freemium sur leur interface habituelle, et propose une option pour être notifié lorsque la recherche est finie. Google le propose aussi pour les utilisateurs de Gemini Advanced (je n’ai pas pu le tester), et Grok le propose en freemium ici (j’ai essayé de le tester, mais j’avais une erreur de Cloudflare 🐛). Ici, on reste sur une interaction plutôt synchrone, rendue possible par des temps de réponse plus courts qu’OpenAI.

🔓 Options ouvertes

Si vous voulez lever le capot, HuggingFace a sorti Open Deep Search, que vous pouvez tester ici. Et, malgré le fait que ça tournait sur du CPU, j’ai pu avoir des résultats en quelques minutes, avec accès à tout le détail des étapes. Dify, une plateforme permettant de créer des agents en low-code, propose un template pour construire sa propre Deep Search. Mes premières expérimentations dessus semblent intéressantes, et j’aime bien la facilité pour le faire évoluer.

Je n’ai pas pu trouver de benchmark intégrant toutes ces options… mais j’ai demandé à Perplexity (le seul que j’ai réussi à vous partager) de le faire pour moi (disclaimer : je ne suis pas très convaincue, surtout de ce qu’il dit sur Dify).

Mettre la main à la pâte

🤖👉💻 Envoyer un LLM à notre place en réunion, ce sera peut-être bientôt possible

Par

Je vous propose de terminer cette issue avec mes notes d’un papier de recherche insolite : MEETING DELEGATE: Benchmarking LLMs on Attending Meetings on Our Behalf rédigé par des chercheurs de l’université de Pékin.

Vous avez bien lu le titre : ces chercheurs se sont demandé s’il était possible de déléguer à un LLM notre présence à une réunion. Quelle bonne idée !

L’objectif est d’envoyer un modèle assister à une réunion à notre place, en lui mettant à disposition une base de connaissance en lien avec le sujet de la réunion et des outils

pour pouvoir générer de l’audio proche de notre voix,

pour prendre la parole ou couper le son,

des composants pour “configurer” l’agent selon plusieurs mode de fonctionnement selon le rôle à jouer :

récolte d’information, création d’engagement, facilitation, …

Ce papier est accompagné d’un benchmark qui révèle des tendances à rester silencieux ou prendre plus la parole selon les modèles étudiés :

Our evaluation reveals that GPT-4/4o maintain balanced performance between active and cautious engagement strategies, while Gemini 1.5 Pro is more cautious, and Gemini 1.5 Flash and Llama3- 8B/70B are more active

🤖 On pourra donc bientôt remplacer nos tasses à café “this meeting should have been an email” par des t-shirts “I should have sent my agent to this meeting”

Au-delà du cynisme que ce papier m’évoque, j’espère que ces travaux, qui n’en sont qu’à leur balbutiement (cf. les parties Limitations et Ethics Statement), en resteront là et que nous garderons la lucidité nécessaire pour annuler nos réunions à faible valeur ajoutée inutiles plutôt que de les déléguer à des modèles.