Le Tech Away revient ce mois-ci avec un changement important : je rédige cette édition du Tech Away (et de prochaines éditions aussi) avec

, avec qui nous discutons régulièrement de veille et qui dirige la practice Machine Learning & GenAI chez OCTO Technology. Si le Tech Away abordait de temps en temps des sujets IA par le passé, attendez vous donc à en voir plus régulièrement :) 🧠🤖Sans plus attendre, voici donc le menu de veille à emporter pour ce mois-ci :

🎄🤖 All I want for Christmas is AGI?

🐄🐈 Environnements éphémères anté-production : arrêtez de faire du "pet", faites du "cattle"

🎙️🤖 4 choses que j’ai apprises à GenerationAI

🪰🐅 Construire des systèmes hautement résilients, TigerBeetle style

🎄🤖 All I want for Christmas is AGI?

Par

Vous aimez les calendriers de l’avant et la GenAI ? Alors vous allez adorer la série de vidéos "12 Days of OpenAI" : 12 vidéos pour présenter des nouveautés chez OpenAI. Plus sérieusement, je voulais vous parler d’une annonce faite dans la 12ème vidéo de cette série : la sortie d’o3 et o3-mini, et leurs capacités de réflexion avancée. Et plus particulièrement de son score sur le benchmark ARC-AGI, annoncé à cette occasion par le Président de l’ARC Prize Foundation.

Mais qu’est-ce ARC-AGI ? C’est un benchmark construit par François Chollet en 2019, conçu pour mesurer la capacité d'abstraction et de généralisation d'une intelligence (artificielle ou naturelle). Je vous invite à regarder des exemples issus du benchmark dans le papier de recherche ou sur une explication plus concise pour mieux comprendre le type de tâches qu’il évalue. Mais, en deux mots, ça ressemble à un test de QI : il s'agit de répondre à une tâche non explicitement définie en la déduisant d'une série d'exemples. Ce sont des problèmes relativement simples pour des humains (environ 75% de bonnes réponses pour une personne recrutée via Mechanical Turk, presque 100% pour une personne diplômée en sciences), mais complexes pour une IA (GPT-3 avait un score de 0% en 2020, GPT-4o de 5% en 2024)… enfin, jusqu’à maintenant.

L’annonce principale de cette vidéo est que le score d’o3 sur ce benchmark a effectué un saut qualitatif par rapport à tous les autres modèles, dépassant par exemple la performance d'un humain moyen sur Mechanical Turk et les 53,5% du meilleur modèle sur Kaggle. Je vous laisse lire ces résultats pour plus de détails sur les scores, parce que c'est compliqué (notamment selon le budget de compute qu’on alloue à o3, le set de données sur lesquels les uns et les autres sont évalués…).

⚠️ Une polémique a éclaté sur les réseaux sur la sincérité de ces résultats. Affaire à suivre…

Donc c’est bon, l’AGI est là ? Alors, non, pas encore. Dans ce thread, François Chollet parle de plusieurs tâches simples qu’o3 n’arrive pas à résoudre, et nous fait un teasing de la version 2 de ce benchmark à présent saturé, pour laquelle o3, entraîné sur les données publiques de la version 1, aurait du mal à performer.

Reste la question des coûts financier 💸 et environnemental 🏭. Aujourd'hui, un humain dans un pays à bas salaire peut résoudre un problème d'ARC-AGI pour moins cher qu'o3 (5$ la tâche contre 20$ pour la version low compute… et quelques milliers de dollars pour le high compute !). Soulignons que le coût financier est forcément corrélé à l’impact environnemental des modèles. Boris Gamazaychikov , head of AI sustainability chez Salesforce a fait le calcul pour nous : la version high compute émet l’équivalent de 5 pleins d’essence par tâche ! C’est 172 fois moins pour la version low compute, et bien sûr virtuellement 0 pour l’humain. Si la tendance à la chute des prix tirée par la concurrence et l’optimisation des calculs se confirme, comme on le voit déjà avec DeepSeek R1 (13 fois moins cher qu’o1 pour le même niveau de performances), cela pourrait néanmoins diminuer fortement. Mais est-il aussi pertinent sur des tâches de la vraie vie ? Rendez-vous à la sortie du modèle pour le découvrir !

L’article du blog d’ARC Prize, analysant les résultats d’o3 sur leur benchmark

🐄🐈 Environnements éphémères anté-production : arrêtez de faire du "pet", faites du "cattle"

Par

Comme je vous en parlais dans la dernière édition, j’ai rédigé un article de blog sur la pratique des environnements éphémères et des review apps.

Voici un lien vers cet article, n’hésitez pas à me dire ce que vous en avez pensé !

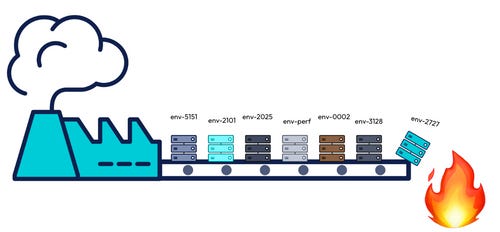

“Pet versus Cattle” est une allégorie couramment utilisée en informatique pour signifier un changement de mindset dans notre rapport aux ressources informatiques. Cet article présente une application de ce principe, non pas comme on le fait habituellement en raisonnant à la maille d’un serveur mais à la maille d’environnements complets. Exit les traditionnels environnements pérennes DEV, UAT, STG, … l’idée ici est de s’outiller pour pouvoir construire et détruire régulièrement des environnements, à chaque fois qu’une hypothèse (de delivery ou de discovery) doit être testée.

ℹ️ La fin de cet article 👆 propose des ressources pour aller plus loin et que j’ai déjà évoqué dans le Tech Away, comme le blog de Werner Vogels (The Frugal Architect) sur l’écoconception, ou encore le blog de Yan Cui (The Burning Monk) sur comment tirer parti des environnements éphémères quand on fait du serverless

🎙️🤖 4 choses que j’ai apprises à GenerationAI

Par

Début décembre, j'ai participé à la conférence GénérationAI, une conférence autour de l’IA générative qui a eu lieu à Paris. Le line-up était très intéressant, avec des acteurs français et internationaux, du monde de la recherche et des grands acteurs de l’écosystème. Voici 4 choses qui m'ont marquée ou que j'y ai apprises.

1. On adore la philosophie Accelerate de Dust

Quelques idées de Gabriel Hubert, CEO de Dust, ont raisonné avec mon esprit Accelerate. Adopter la GenAI en entreprise en la mettant rapidement entre les mains des utilisateurs pour aborder le problème par la valeur métier. Une belle façon d'aller en production au plus vite plutôt que de se perdre dans du sur-design 🔥. J'ai retenu de l'approche proposée le besoin d'outiller et former toute l'organisation à la GenAI. Et, bien sûr, rendre accessible largement la donnée de l'entreprise pour découvrir des cas d'usage utiles et souvent transverses.

Et c'est vrai que Dust est un formidable outil pour embarquer les métiers sur les cas d’usage de l’IA (je travaille avec en ce moment). Mais n’oublions pas que Dust ne peut pas tout faire, et que l’intégration d’outils complémentaires, notamment d'observabilité, reste essentielle pour passer à l'échelle et fiabiliser les cas d'usage les plus stratégiques. Je vous parlerai de mon REX probablement lors d'un prochain épisode !

2. OpenAI : toujours les rois de la démo

Vous n'avez pas encore reçu un coup de fil de ChatGPT ? Katia Gil Guzman, la speakeuse d'OpenAI, si. Incarnant une cliente voulant échanger son téléphone défectueux, elle demande à ChatGPT des informations sur les produits disponibles dans une boutique. Ce dernier appelle la (fausse) boutique (dont elle interprète également la responsable). Et a une discussion à un niveau quasi-humain avec elle. J'ai hâte de me faire spammer par ChatGPT au téléphone 🥲.

Pro tip : si votre interlocuteur est beaucoup trop enthousiaste au sujet des couleurs de téléphone disponibles dans votre boutique... c'est que c'est une IA

3. Un des indicateurs de performance mesurés par l'équipe Gemma est la "finetunnabilité" de ses modèles

Thomas Mesnard, co-auteur de Gemma, nous a partagé qu'un des critères d'évaluation de leurs modèles était leur "finetunnabilité". Quésako ? D’après notre speaker, c'est être capable de sortir facilement de sa "vallée de convergence” sans besoin de trop de données supplémentaires.

On saluera cette démarche centrée utilisateurs : un des principaux cas d'usage pour les modèles open-source est en effet de les spécialiser sur un contexte, des données ou une tâche précises. À quand un benchmark pour nous aider à choisir le modèle le plus "finetunnable" ?

4. Votre few-shots learning atteint ses limites ? Rendez-le dynamique !

Michal Valko, chercheur chez Meta, part de ce constat : lorsqu'un agent a besoin de réaliser des tâches trop diversifiées, les exemples de son prompt ne sont pas toujours adaptés à la tâche à effectuer. Il nous propose donc une approche dynamique (voir son papier) :

Constituer un référentiel d’exemples ;

Utiliser un (grand) LLM pour labelliser les compétences associées à chacun de ces exemples (trigonométrie, algèbre, ...) - ces labels sont suggérés par le LLM ;

Utiliser un (petit) LLM pour déterminer les compétences nécessaires à l'accomplissement de la requête de l'utilisateur ;

Injecter dynamiquement des exemples correspondant à ces compétences en tant qu'exemples pour le few shot learning

Les résultats sont intéressants. À utiliser uniquement si le few-shot ne marche pas, bien sûr #yagni

Pour aller plus loin

Le récapitulatif de la conférence dans la newsletter de GenerationAI

Le papier de recherche de Gemma

Le papier de recherche sur l’approche dynamique du few-shot learning

🪰🐅 Construire des systèmes hautement résilients, TigerBeetle style

Par

Fin 2024, j’ai découvert TigerBeetle, une nouvelle base de données implémentée from scratch pour répondre à des cas d’usage de transactions financières distribuées, avec l’ambition d’être 1000x plus performante que les systèmes à l’état de l’art en 2021 (rien que ça).

J’ai découvert cette base de données au travers d’une présentation de celle-ci, animée par Joran Greef, le fondateur de la société au même nom que la base de données. Et c’est une des présentations tech qui m’a le plus impressionné ces 5 dernières années (en termes de rythme, de delivery, de patte graphique, ou simplement par le sujet) !

Il avance quelques arguments intéressant pour justifier la construction de cette base à partir de zéro, voici quelques citations piochées dans la vidéo :

On ne peut pas construire un système financier performant en prenant une base general purpose et en y rajoutant 10.000 lignes de code d’enregistrement de débits et de crédits

Nous vivons dans un monde de + en + transactionnel : les systèmes financiers doivent fonctionner mille fois plus vite qu’auparavant, car les transactions deviennent plus petites et plus fréquentes

Les bases de données les plus populaires (Postgres, MySQL, …) ont entre 20 et 30 ans et ont été conçues pour un monde et une échelle différents

Pour construire une telle base de données, des choix forts ont été fait comme coder dans le langage Zig, miser sur un modèle de scalabilité vertical plutôt qu’horizontal, ou développer un système custom de gestion des pannes de disque.

En particulier, ils ont adopté une méthodologie de programmation et de test qu’ils ont nommé “programmation TigerBeetle style”, inspirée des 10: Rules for Developing Safety-Critical Code de la NASA 🚀

On peut noter par exemple :

avoir des assertions présentes dans le code source, évaluées au runtime pour vérifier la validité de propriétés du système et générer automatiquement des issues Github en cas de crash avec les éléments de contexte nécessaires pour reproduire le bug,

privilégier l’allocation de mémoire statique à une allocation dynamique,

ou encore mettre en place un système de simulation déterministe permettant de tester le fonctionnement de la base de données pendant l’équivalent de plusieurs siècles en l’espace de quelques jours, avec un simulateur capable d’accélérer le temps 🤯

🎮 Et comme ce sont des passionnés, ils ont habillé leur simulateur à la manière d’un jeu vidéo, avec des animations pour les requêtes entre les nœuds, les pannes disques, les pannes réseaux, l’isolation du quorum …

La vidéo de présentation de cette base de données

10min de présentation, 10min de démo, 20 min d’échanges avec l’hôte @ThePrimeagen

La documentation des guidelines TigerBeetle Style